Como o CERN, fazendo uso do Linux e de ferramentas OpenSource, colabora para com a comunidade global de desenvolvedores?

| Se você apoia nosso site, desative o AdBlock quando visitá-lo, inclusive em Mobile!

Os anúncios são poucos e não invasivos. Se quiser contribuir com nosso trabalho, clique em qualquer banner de sua preferência, exceto dos Parceiros. Mais detalhes clicando aqui.

CERN

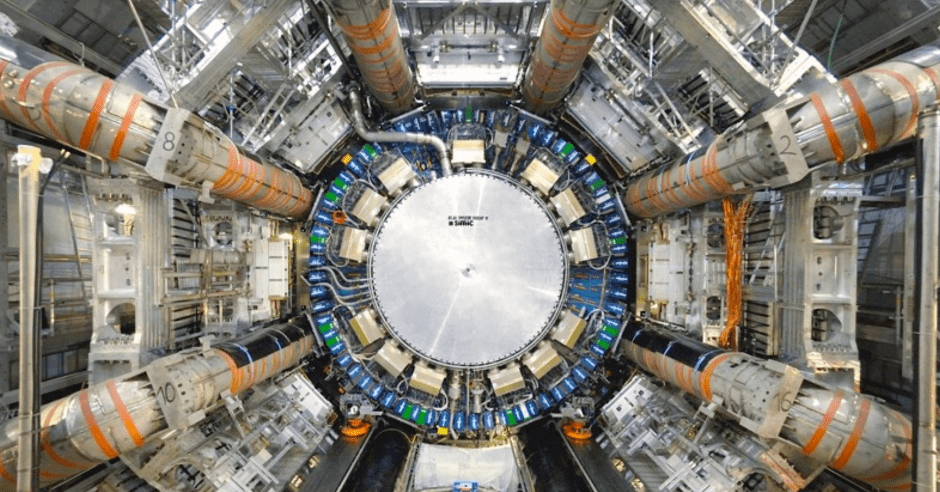

O CERN dispensa introduções. Entre outras coisas, a Organização Européia para Pesquisa Nuclear (CERN) criou no início da era da Internet, o World Wide Web; e na contemporaneidade o Large Hadron Collider (LHC), o maior acelerador de partículas do mundo, que foi usado na descoberta do bóson de Higgs. Tim Bell, responsável pelo grupo de Sistemas Operacionais e Infraestrutura de TI da organização, diz que o objetivo de sua equipe é “fornecer a instalação de computação para 13.000 físicos em todo o mundo para analisar essas colisões, entender do que o universo é feito e como ele funciona.”

O CERN está conduzindo uma ciência pesada, especialmente com o LHC, que gera grandes quantidades de dados quando está em atividade. “O CERN armazena atualmente cerca de 200 petabytes de dados, com mais de 10 petabytes de dados chegando a cada mês quando o acelerador está em funcionamento. Isso certamente produz desafios extremos para a infra-estrutura de computação, com relação ao armazenamento dessa grande quantidade de dados, bem como a capacidade de processá-los em um prazo razoável. Isso pressiona as tecnologias de rede e armazenamento e a capacidade de fornecer uma estrutura de computação eficiente ”, disse Bell.

A escala em que o LHC opera e a quantidade de dados que gera representam alguns desafios intensos. Mas o CERN não é novo para esses problemas. Fundado em 1954, o CERN existe há cerca de 60 anos. “Sempre enfrentamos desafios de computação que são problemas difíceis de resolver, mas estamos trabalhando com comunidades de código aberto para resolvê-los”, disse Bell. “Mesmo nos anos 90, quando inventamos a World Wide Web, estávamos procurando compartilhar isso com o resto da humanidade, a fim de sermos capazes de nos beneficiar das pesquisas feita no CERN e o open source foi o veículo certo para fazer isso”.

OpenStack e CentOS

Hoje, o CERN é um grande usuário do OpenStack, e Bell é um dos membros da diretoria da OpenStack Foundation. Mas o CERN foi fundado bem antes do OpenStack. Por vários anos, eles vêm usando várias tecnologias de código aberto para fornecer serviços por meio de servidores Linux.

“Nos últimos 10 anos, descobrimos que, em vez de resolvermos nossos problemas, encontramos comunidades de código aberto com as quais podemos trabalhar, que enfrentam desafios semelhantes e, depois, contribuímos para esses projetos em vez de inventar tudo sozinhos. ter que mantê-lo também”, disse Bell.

Um bom exemplo é o próprio Linux. O CERN costumava ser um cliente do Red Hat Enterprise Linux. Mas, em 2004, eles trabalharam com o Fermilab para construir sua própria distribuição Linux chamada Scientific Linux . Por fim, perceberam que, por não estarem modificando o kernel, não havia sentido em gastar tempo criando sua própria distribuição; então eles migraram para o CentOS. Como o CentOS é um projeto totalmente open source e orientado pela comunidade, o CERN poderia colaborar com o projeto e contribuir para a forma como o CentOS é construído e distribuído.

O CERN ajuda o CentOS com infraestrutura e também organiza o CentOS DoJo no CERN, onde os engenheiros podem se reunir para melhorar o empacotamento do CentOS.

Além do OpenStack e do CentOS, o CERN é um usuário pesado de outros projetos de código aberto, incluindo o Puppet para gerenciamento de configuração, Grafana e influxDB para monitoramento, e está envolvido em muitos outros.

“Colaboramos com cerca de 170 laboratórios em todo o mundo. Então, toda vez que encontramos uma melhoria em um projeto de código aberto, outros laboratórios podem facilmente pega-la e usá-la”, disse Bell,“ao mesmo tempo, também aprendemos uns com os outros. Quando instalações em larga escala, como eBay e Rackspace, fazem alterações para melhorar a escalabilidade de soluções, isso nos beneficia e nos permite dimensionar.”

Resolvendo problemas reais

Por volta de 2012, o CERN estava procurando formas de dimensionar a computação para o LHC, mas o desafio eram as pessoas, e não a tecnologia. O número de funcionários que o CERN emprega é fixo. “Tivemos que encontrar formas de dimensionar a computação sem exigir um grande número de pessoas adicionais para administrá-la”, disse Bell. “O OpenStack nos forneceu uma infraestrutura automatizada, definida por software e orientada por API. O OpenStack também permitiu que o CERN analisasse problemas relacionados à entrega de serviços e depois os automatizasse, sem precisar dimensionar a equipe.”

“Atualmente, estamos executando cerca de 280.000 núcleos e 7.000 servidores em dois data centers em Genebra e em Budapeste. Estamos usando infra-estrutura definida por software para automatizar tudo, o que nos permite continuar a adicionar mais servidores, permanecendo dentro da mesma quantidade de funcionários ”, disse Bell.

Com o passar do tempo, o CERN estará lidando com desafios ainda maiores. O Large Hadron Collider tem um roteiro definido para 2035, incluindo uma série de atualizações significativas. “Executamos o acelerador por três a quatro anos e depois temos um período de 18 meses ou dois anos quando atualizamos a infraestrutura. Este período de manutenção nos permite também fazer algum planejamento de computação”, disse Bell. O CERN também está planejando o upgrade do Large Luminosity Large Hadron Collider, que permitirá feixes com maior luminosidade. A atualização significaria cerca de 60 vezes mais necessidade de computação em comparação com o que o CERN tem hoje.

“Com a Lei de Moore, talvez tenhamos um quarto do caminho até lá, então temos que encontrar maneiras pelas quais podemos escalar o computador e a infraestrutura de armazenamento de forma correspondente e encontrar automação e soluções como o OpenStack ajudarão nisso”, disse Bell.

“Quando começamos o grande colisor Hadron e vimos como forneceríamos a computação, ficou claro que não poderíamos colocar tudo no data center do CERN, então planejamos uma estrutura de grade distribuída, com nível zero no CERN e em seguida, uma estrutura em cascata em torno disso “, disse Bell. “Há cerca de 12 grandes centros de nível 1 e 150 pequenas universidades e laboratórios em todo o mundo. Eles recebem amostras dos dados do LHC para ajudar os físicos a entender e analisar os dados.”

Essa estrutura significa que o CERN está colaborando internacionalmente, com centenas de países contribuindo para a análise desses dados. Tudo se resume ao princípio fundamental de que o código aberto não é apenas o compartilhamento de código, mas também a colaboração entre as pessoas para compartilhar conhecimento e alcançar o que nenhum indivíduo, organização ou empresa pode alcançar sozinho. Esse é o bóson de Higgs do mundo do código aberto.

#UrbanCompassPony

Fonte:

Linux.com

Autodidata, me aprofundei em sistemas operacionais baseados em UNIX®, principalmente Linux. Também procuro trazer assuntos correlacionados direta ou indiretamente, como automação, robótica e embarcados.